Jakarta, Gizmologi – Perkembangan teknologi AI yang terus berjalan, memungkinkan hadirnya model yang mampu melakukan penalaran lebih kompleks. Salah satu yang terbaru adalah DeepSeek R1, sebuah model open-source yang dirancang untuk melakukan inferensi berulang guna menghasilkan jawaban terbaik. Berbeda dengan model AI tradisional yang langsung memberikan respons, DeepSeek R1 menggunakan metode seperti chain-of-thought, consensus, dan pencarian untuk memastikan akurasi dan relevansi jawaban.

Dalam prosesnya, DeepSeek R1 membutuhkan komputasi yang sangat tinggi. Model ini menghasilkan lebih banyak token output dan memiliki siklus generasi yang lebih panjang, sehingga kualitasnya terus meningkat seiring dengan waktu pemrosesan yang lebih besar. Untuk mendukung kebutuhan tersebut, penggunaan komputasi yang dipercepat menjadi kunci utama, di mana Nvidia hadir sebagai pemain utama dalam menyediakan infrastruktur yang diperlukan.

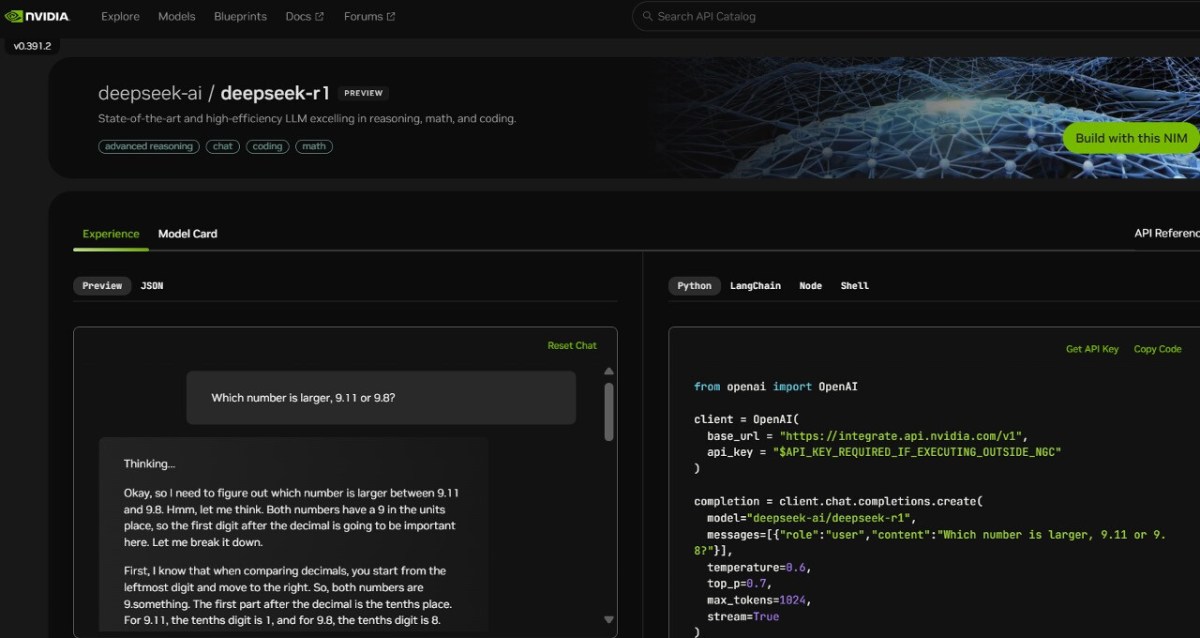

DeepSeek R1 kini tersedia sebagai microservice Nvidia NIM dalam tahap pratinjau di build.nvidia.com. Dengan dukungan dari Nvidia, model ini mampu menghadirkan performa inferensi yang cepat dan efisien. Ini memberikan peluang bagi para pengembang untuk bereksperimen serta membangun agen AI yang lebih canggih dan aman.

Baca Juga: Microsoft dan DeepSeek: Saling Mendukung untuk Ekspansi Maksimal

Keunggulan DeepSeek R1 dalam AI Berbasis Penalaran

DeepSeek-R1 tidak hanya menghasilkan respons berdasarkan satu kali inferensi, tetapi melakukan beberapa iterasi untuk mencapai jawaban terbaik. Proses ini, yang dikenal sebagai test-time scaling, memungkinkan model untuk “berpikir” lebih lama dan lebih dalam, menghasilkan keluaran yang lebih akurat dan logis.

Model ini menggunakan pendekatan mixture-of-experts (MoE) dengan total 671 miliar parameter. Setiap lapisan DeepSeek R1 memiliki 256 ahli (expert), dengan setiap token dievaluasi oleh delapan ahli yang berbeda. Hal ini membuat model ini jauh lebih besar dibandingkan model-model AI open-source lainnya yang umumnya hanya memiliki sepersepuluh dari kapasitas tersebut.

Dengan memanfaatkan microservice Nvidia NIM, DeepSeek R1 dapat menghasilkan hingga 3.872 token per detik pada sistem Nvidia HGX H200. Teknologi Nvidia NeMo juga memungkinkan perusahaan untuk menyesuaikan DeepSeek R1 sesuai dengan kebutuhan mereka, menjadikannya solusi fleksibel untuk berbagai kasus penggunaan AI.

Infrastruktur Nvidia untuk Menunjang DeepSeek R1

Untuk menjalankan DeepSeek-R1 secara optimal, diperlukan banyak GPU dengan kinerja komputasi tinggi. Kombinasi delapan GPU Nvidia H200 yang terhubung melalui NVLink memungkinkan model ini berjalan dengan efisiensi tinggi, memanfaatkan bandwidth 900 GB/s untuk komunikasi antar ahli dalam model MoE.

Dengan kehadiran Nvidia NIM microservice, pengembang dapat dengan mudah mengintegrasikan DeepSeek R1 ke dalam sistem mereka tanpa harus menangani kompleksitas deployment secara manual. Microservice ini mendukung API standar industri, sehingga perusahaan dapat mengimplementasikan AI mereka dengan lebih aman dan sesuai dengan kebijakan privasi data.

Nvidia juga tengah mempersiapkan arsitektur generasi berikutnya, Blackwell, yang akan semakin meningkatkan kinerja model AI berbasis penalaran. Dengan Tensor Cores generasi kelima, Blackwell akan menghadirkan peningkatan performa hingga 20 petaflops untuk komputasi FP4 dan NVLink domain yang mampu menghubungkan hingga 72 GPU secara optimal.

DeepSeek R1, dengan dukungan Nvidia, membawa AI berbasis penalaran ke level yang lebih tinggi. Kombinasi antara arsitektur model yang canggih dan infrastruktur komputasi Nvidia menjadikannya salah satu solusi paling kuat untuk inferensi AI masa kini dan masa depan.

Eksplorasi konten lain dari Gizmologi.id

Berlangganan untuk dapatkan pos terbaru lewat email.